理想的翻译视频应具备以下特性:字幕准确、长度适宜,配音音色与原声一致,且字幕、声音、画面完美同步, 出于易用性考虑,软件默认配置并非最佳,你可以参考以下说明,自行调整每个步骤的最佳配置。

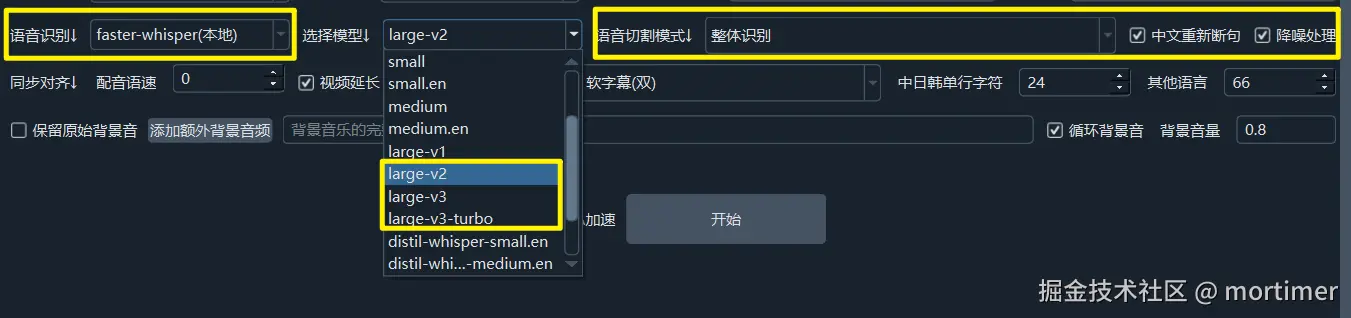

第一步:语音识别

目标: 将视频中的语音转换为对应语言的字幕文件。

对应控制元素: “语音识别”行

非中文最佳配置:

- 免费

open-whisper(本地)faster-whisper(本地),模型选择large-v3 - 收费 OpenAI API 接口

- 免费

中文最佳配置:

- 免费 Qwen-ASR(本地)

- 收费:

阿里百炼ASR豆包语音识别大模型

日语最佳

- 免费: Huggingface_ASR->

kotoba-tech/kotoba-whisper-v2.0或reazon-research/japanese-wav2vec2-large-rs35kh

- 免费: Huggingface_ASR->

小语种最佳配置:

- 收费:

Gemini大模型识别 - 收费:openai-api

- 收费:

注意: 如果没有N卡或未配置CUDA环境未启用CUDA加速,使用本地模型时处理速度极慢。显存不够大时可能崩溃。

第二步:字幕翻译

目标: 将第一步生成的字幕文件翻译成目标语言。

对应控制元素: “翻译渠道”行

最佳配置:

- 首选AI渠道(收费): OpenAI ChatGPT(gpt-5.2模型) 、Gemini(gemini-3-pro模型)、DeepSeek

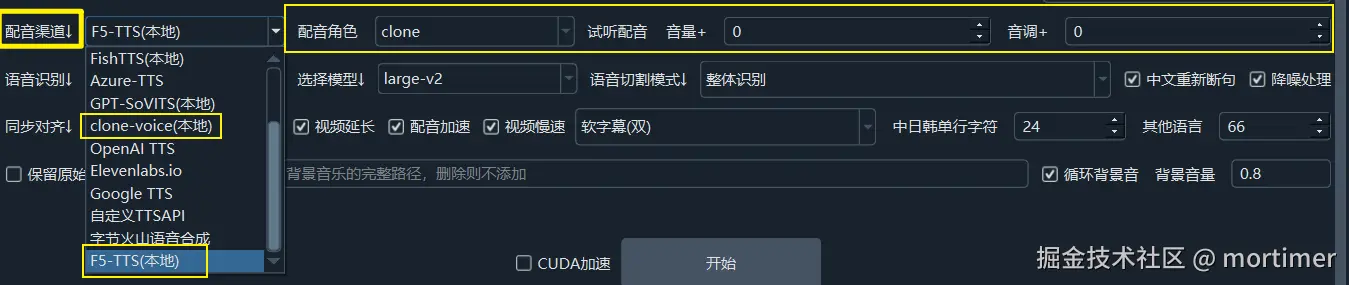

第三步:配音

- 目标: 根据翻译后的字幕文件生成配音。

- 对应控制元素: “配音渠道”行

- 最佳配置:

- 免费:Edge-TTS: 免费并支持所有语种

- 免费:中英日韩:

Qwen-TTS(本地)、F5-TTS/Index-TTS/GPT-SOVITS/CosyVoice(本地) - 收费: 豆包语音合成2.0 / Qwen-TTS(bailian) / 302.AI / Minimaxi / OpenAI-TTS

- 克隆语音:Qwen-TTS(本地)、GPT-SOVITS、CosyVoice、F5-TTS、Index-TTS、Chatterbox

第四步:字幕、配音、画面同步对齐

- 目标: 将字幕、配音和画面进行同步处理。

- 对应控制元素:

同步对齐行

- 最佳配置:

- 选中二次识别,将在配音完成后对配音文件再次语音识别生成时间轴精准的字幕

- 中文翻译成英文时,可设置

配音语速值 (例如10或15) 以加快配音速度,因为英文句子通常较长。 - 选中

配音加速和视频慢速2个选项,强制对齐字幕、声音和画面,也可以两者只选中一个。

第五步:其他有助于质量提升的选项

- 选中

发送完整字幕,同时选中菜单-工具-高级选项-AI翻译附带完整原字幕,并将AI翻译渠道每批次字幕行数设为100或更大,将得到更好的翻译质量,但注意,必须使用具有极大上下文的在线AI大模型,例如 GPT-5.2/Gemini-3-pro/DeepSeek-v3.2等 - 如果选择了

clone角色,即需要克隆原说话人的音色,那么点击主界面的设置更多参数,将最短持续毫秒设为3000或大于3000的整数值,将最长语音持续秒数设为6到10的数字,同时选中分离人声背景声,否则克隆质量不佳或出错 - 选中

降噪选项

输出视频质量控制

- 默认输出为有损压缩。若需无损输出,请在菜单 - 工具 - 高级选项 - 视频输出控制区域,将

视频转码损失控制设置为 0:

- 注意:如果原始视频非 mp4 格式或使用了嵌入式硬字幕,则视频编码转换会造成一定损失,但损失通常微乎其微。 提高视频质量会显著降低处理速度并增加输出视频大小。